人工智慧時代的思考權:在堅守與讓渡之間

正在被悄然讓渡的思考權

科幻作品常以《終結者》式的暴力對抗描繪人工智慧(AI)的威脅,但現實中AI的侵蝕遠比銀幕敘事更安靜、更隱蔽——它無關肉體毀滅,而關乎存在根本: 一場針對人類「思考權」的系統性讓渡,正在我們與效率的合謀中悄然發生。

在一個崇尚效率的時代,這種讓渡無處不在:從學生提筆便求諸AI,到企業倚之生成行業報告,直至本為知識聖殿的學術界亦不能外。 當論文寫作開始迎合演算法,學術成果也交由AI審閱時,自主思考便已被悄然外包,知識生產由此陷入一種「自我蠶食」:知識勞動者既是餵養模型的數據源,其獨立思考的空間,也正在被自己哺育的技術擠壓和反噬。

與 AI 協作固然提高效率,但隨之而來的思考權讓渡令人擔憂。 讓渡的動機複雜:有時雖源於難以自控的依賴(上癮),更多時候則是知識工作者在資訊過載與注意力瀕臨極限下的被迫應對。 然而,一個根本性的危機隨之浮現: 倘若從重要的思考、選擇,到「何為知識」的標準都讓渡給技術系統,那麼人類主體性還剩下什麼?

我們究竟是宇宙演化長河中的匆匆過客,還是仍要堅守「人工智慧終究應服務於人類福祉」的價值底線? 若認同後者,我們至少必須回答兩個問題:

- 在看似中立的技術系統中,思考權讓渡的度在哪裡,其隱形風險與邊界究竟在何處?

- 當演算法正在重塑我們的工作和思考方式時,教育系統應該如何從根本上進行重構,才能捍衛我們自己的思考權與自主性?

在這個時代,我們所捍衛的「思考權」,絕非僅指拒絕被演算法操縱的消極自由,而是一種積極的認知主權。 它意味著我們不能滿足於做「在選項中打勾的人」,而必須堅持做「定義選項的人」; 不僅具備審視演算法輸出的判斷力,更要保有主動提出問題、構建獨創性框架、併為技術設定倫理航向的建設性思考能力。

思考的邊界:警惕演演算法的「中立性幻象」

引言中第一個問題的答案很難一蹴而就,本文只就其中關鍵的一點風險展開討論。 公眾往往對 AI 抱有一種危險的想像:認為它是客觀、中立的「知識分發器」。 但我們團隊關於「立場漂移」 (Stance Drift) 的工作論文揭示了相反的現實。

在評估當前AI在傳達與識別立場與態度「的實驗中,我們發現: AI 既非忠實的描述者,亦非無偏的提取者。 研究表明,當前主流大模型在傳遞觀點時的立場保持率(SPR)平均不足 60%。 更令人擔憂的是,這種「不忠實」並非隨機雜訊,而呈現出系統性的偏離:

- 極端化(Polarization): 將溫和觀點推向更極端;

- 傾向性引導: 將中立態度引向特定傾斜;

- 原意反轉(Stance Flipping): 甚至直接顛倒原意。

「立場漂移」在實際應用中極具迷惑性。 例如,當學生向 AI 諮詢一個充滿灰度的複雜社會議題時,演算法可能會抹去那些「混亂」的中間地帶,將現實簡化為非黑即白的漫畫式對立。 這種「去噪」實際上是對現實複雜度的閹割,學生以為自己得到了總結,實際上卻被迫接受了一種被扭曲的世界觀。

「立場漂移」至少揭示了兩個關鍵事實:

第一,技術從來不是中立的工具。 演算法不是在真空中運行,而是深度鑲嵌在訓練數據、模型微調方式與現實權力關係之中。 它不僅「提供答案」,還在悄然塑造「什麼樣的答案更可見、更被認為是合理的」。 AI不只是在傳遞觀點,更在重寫公共討論的呈現形式與重心。

第二,權威正在從「可質詢的人」轉移到「不可見的系統」。 當學生、家長、教師、政策制定者越來越多地依賴 AI 來「總結文獻、判斷立場、提供建議」時,真正被讓渡的,不只是一次次查詢的權利,而是對真偽、是非、輕重緩急進行自主思考的能力。

如果教育只教學生「如何高效使用 AI」,而不重視「如何審視與質詢 AI」,未來的社會權威將悄然從人類轉移到演算法,從可追責的主體轉移到「不知向誰追責」的系統。 在 AI 時代,大學如果只是技術的追隨者而非審判者,將被動地成為「演算法偏見」的擴音器。 大學理應成為技術的批判性論壇(Critical Forum),而非技術神話的傳播部。

思考的能力:AI時代的核心素養與教育轉向

思考權的讓渡不僅發生在知識生產領域,也正在重塑勞動力市場。 過去數十年,高等教育普遍遵循一個簡潔公式:

知識輸入 + 技能訓練 = 入門級專業工作

這一公式在信息相對稀缺的時代曾經穩固可靠——彼時,擁有知識本身就是核心競爭力。 然而,當 AI 讓資訊的獲取變得便捷,稀缺資源已從「獲取知識」徹底轉移到了「對知識的判斷」與「對責任的承擔」。

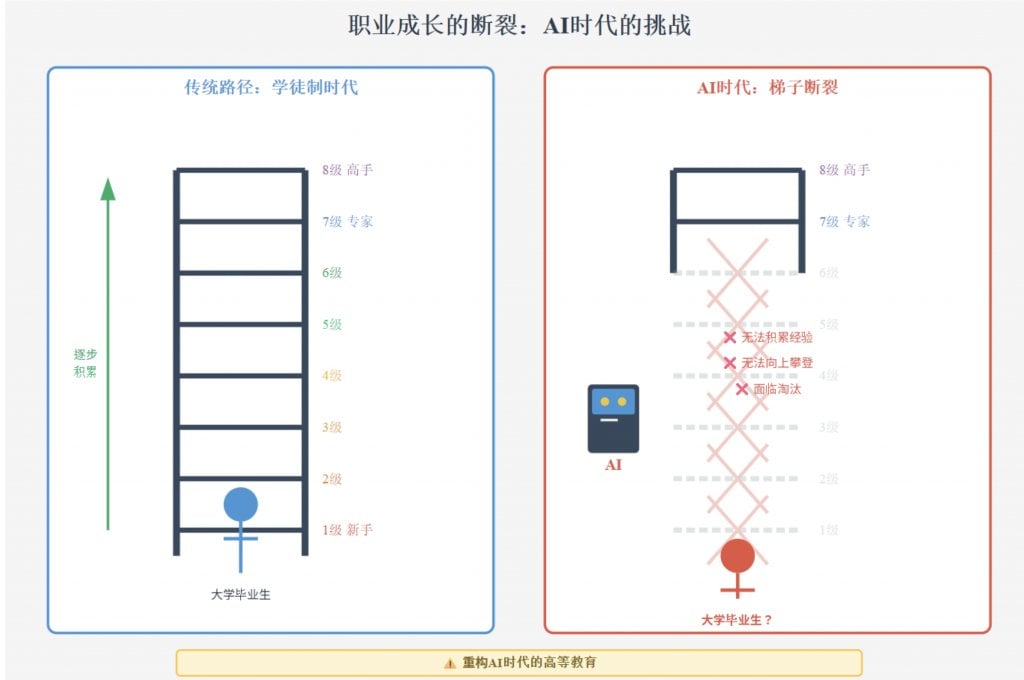

現實已然殘酷:根據哈佛大學經濟學家Hosseini與Lichtinger的研究 (Lichtinger G, Hosseini Maasoum S M., 2025),僅在 2023–2024 年間,全球入門級專業崗位就減少了約 22%。 初級分析師、初級諮詢顧問等曾是高等教育的主力培養物件,如今卻正在被更高效的 AI 系統部分取代。 大量基於「可編碼規則 + 標準化輸入輸出」的工作,被迅速自動化。

這不是簡單的「失業」,這意味著,高校為求職準備的「技能包」,在走出校門那一刻,可能已經過時了。

但比失業更隱蔽、更致命的危機,是「學徒期的消失」(The Apprenticeship Gap)— 我們失去了」成為高手「的必經之路。 試想,一個想成為頂尖外科醫生的人,若AI接管了所有縫合、止血等實習醫生的基礎工作,他該在哪裡練習手感、積累「下刀」的直覺? 一個未來的戰略顧問,若AI直接給出了完美的分析報告,他又該在哪裡,從處理雜亂數據中學會發現真問題?

這些枯燥的初級工作,從來不只是任務,更是職業的「新手村」和「練級區」。 新手正是在大量「犯錯-糾正」的迴圈中,默默練就了行業最寶貴的隱形直覺。 如今,AI高效地拆毀了這個訓練場和新手攀登的機會。 一個可怕的斷層正在出現:未來的專家,將從哪裡來?

在這場結構性變遷中,若人類仍固守「技能」層面的競爭,將不可避免地陷入與機器的硬碰硬的較量。 更深層次的問題在於:當思考被簡化為對AI作品的「通過」或「駁回」,人類是否甘於永遠做那個「按下確認鍵的人」? 如果我們的判斷力,萎縮到只剩下「接受推薦」或「拒絕推薦」,而非「提出關鍵問題」和「建構獨特標準」,那麼,人類還在多大程度上掌握著自身命運?

這迫使教育必須正面回應「梯子斷裂」后的挑戰:既然職場不再提供「幹中學」的學徒機會,大學就必須進化為新的「練級場」。教育的使命,發生根本性變更。

大學,必須從「知識儲備倉」,轉型為「高保真能力模擬器」。

香港大學經管學院經研討后提出:須在校園環境中,前置原本需要在工作中積累的複雜決策訓練。 需要通過高保真的類比以及與公司合作的實戰,讓學生在畢業前,就習得那些原本通過大量基礎工作才能「磨」出來的直覺、魄力和判斷力。 教育的核心交付物,必須從「標準化技能」轉向那些能夠直接駕馭複雜系統、且無法被演演算法輕易類比的核心素養(Competencies)(以下以企業引入AI招聘系統為例,展示五種素養的協同作用):

- 批判性思維(Critical Thinking): 拆解複雜問題,識別問題背後隱藏的假設、數據偏見、系統性漏洞。 例:當看到「AI招聘系統效率提升25%」,你問「這個數據來自於什麼樣本? 它是否無意中篩掉了某些背景的候選人? 」

- 創造力(Creativity): 不僅發現問題,更能重新定義問題,構想替代方案與新的可能性。 例:你不只是調整現有招聘流程,而是能設想「如何在保證效率的同時,讓更多元的人才被看見」的流程創新。

- 同理心(Empathy): 穿透數據與流程,看見被影響的具體的人及其真實處境。 例:你感知到被AI篩掉的求職者的失落,HR部門的兩難,演算法工程師的壓力; 這讓你的決策不會淪為冰冷的優化。

- 判斷力(Judgment): 當所有資訊都已分析,所有方案都已推演,所有利益相關者都被理解后,你仍需在不確定性和價值衝突中做出可承責的選擇。 例:這個系統改進還是停用? 改進需要多少投入? 誰承擔失誤成本? 這些問題沒有優雅的答案,只有艱難的權衡。

- 領導力(Leadership): 將個人的判斷轉化為集體行動,在技術與人的張力中堅守原則。 例:就一個看似低效的決定說服董事會(放慢部署以確保公平); 激勵團隊在商業壓力下不放棄道德底線。

這些能力不僅是職業護城河,更指向一個核心目標:賦予人類駕馭演演算法的主體性,讓技術服務於人的福祉,而不是把人降格為技術系統中的「可替換零件」。

思考的重構: 重寫高等教育的底層架構

如果我們真心希望培養的是能夠駕馭 AI、而非被 AI 反向塑造的未來領導者,那麼零散的課程修補已遠遠不夠。 高等教育必須突破傳統學科邊界,從底層重新想像大學的結構與功能。 香港大學經管學院最新推出的「創領未來學士」(Bachelor of Global Leadership, Innovation & Society,簡稱 BGLIS),並非只是一個新增的學位專案,而是一個用於驗證未來教育邏輯的「制度性原型」(institutional prototype)。 它嘗試回應一個普適性的提問:在演算法時代,高等教育的底層架構應當如何被重寫?

我們將這一探索歸納為一種通用的教育邏輯——若從零開始為 AI 時代設計一套商科教育,無論其具體名稱為何,它都至少應建立在三大支柱之上:

- AI 作為基石(AI as Foundation): 學生必須理解 AI 的結構與邏輯。 這並非為了讓人人成為工程師,而是為了具備「審計演算法」的能力——明白何時該信任系統,何時該質疑黑箱,從而學會塑造、調控它。

- 人文作為指引(Humanities as Compass): 通過哲學、歷史、倫理的訓練,讓學生具備批判能力和價值判斷力,能夠在技術繁盛之時,追問「我們要往哪裡去」。

- 商業作為實踐(Business as Impact): 讓學生真正把技術與人文結合起來,在組織與市場中創造可持續的社會價值。

在這一框架下,BGLIS 致力培養的不是標準化的「執行者」,而是具備道德羅盤的「負責任的創新者」(Responsible Innovators)。 通過跨學科課程、全球沉浸式學習以及圍繞真實社會問題的專案實踐,學生不僅要「會使用 AI」,更要學會在價值衝突中為 AI 設定邊界,並在關鍵議題上引導技術朝人類希望的方向發展。

結語:守護人的思考權——定義命運的最後防線

人工智慧在加速奔跑,資本與平臺邏輯在不斷推動技術擴張。 知識被批量採集、拆解與再包裝,公共討論被簡化為可優化的「流量」。 在此浪潮中,如果教育僅僅滿足於培養「高效使用AI的操作員」,我們將在無形中催生一種危險的「知識霧霾」:資訊充盈而判斷力貧瘠,答案易得而責任意識稀薄,技術熟練而價值感茫然。

因此,大學的使命,絕不能退守為新一輪的職業培訓。 它必須重新自覺地承擔起作為文明燈塔和技術批判者的職責:

- 在知識層面,成為技術的「解碼者」:不滿足於使用介面,而要揭示技術背後的前提與偏見;

- 在價值層面,成為人性的「捍衛者」:在效率至上的敘事外,守住人類尊嚴與福祉的底線;

- 在制度層面,成為規則的「共創者」:推動建立對 AI 負責任使用的規範與治理框架。

我們尚未掌握所有答案,但方向已經足夠清晰:教育的終極使命,不是生產更高效的「工具」,而是無法被演算法化的「完整的人」。 它必須在技術轟鳴中,守護人的主體性; 它必須培養的,是能在模糊中判斷、在數據中看見他人、在不確定中引領方向的靈魂。 唯其如此,下一代才能不淪為技術浪潮中的無根的浮木,而成為有資格、有能力參與制定規則、校準方向、敢於對技術說「不」的公民。

這已不僅是對未來職業的功利性回應,這是一場關乎存在的辯護:在萬物皆可被計算、被優化的時代,我們所要捍衛的,是人類追問「何為至善」的終極特權。 這份古老而高貴的權威,不在於我們能給出多快的答案,而在於我們永不放棄對既有系統發問,並依憑主體意志,為人類的尊嚴,書寫屬於自己的回答。

作者:童欣,奚茜 (香港大學經管學院)