Groq技術崛起 ︳初創LPU技術挑戰Nvidia GPU 、AMD和Intel (內含試用連結)

官網試用 https://groq.com/

AI晶片Groq技術崛起 ︳ 大量簡單資料處理效率勝Nvidia

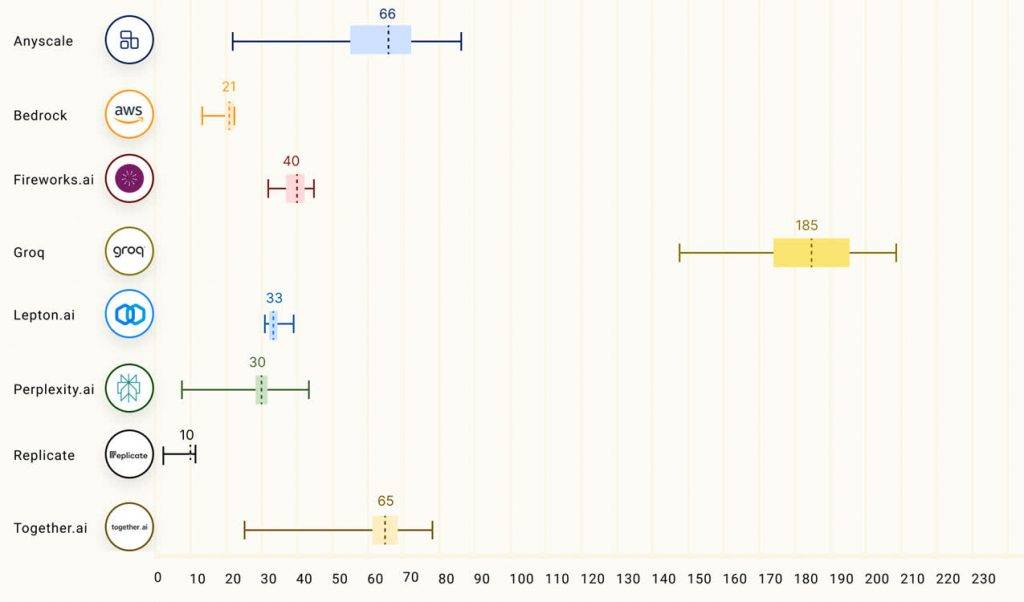

Groq創辦人Jonathan Ross指出,LPU成功繞過GPU和CPU在處理LLM時的兩大瓶頸,即運算密度和記憶體頻寬,使得回應效率大幅提升。Groq擁有230MB靜態隨機存取記憶體(SRAM)同每秒80 TB的記憶體頻寬,優於傳統的CPU和GPU配置。雖然Groq的LPU主要用於運行LLM,而不是原始運算或模型微調,但在大量簡單資料(INT8)的處理效率上,與Nvidia旗艦A100 GPU相比,Groq LPU優勝。然而,當處理更複雜的資料處理任務(FP16)時,A100仍然保持優勢。

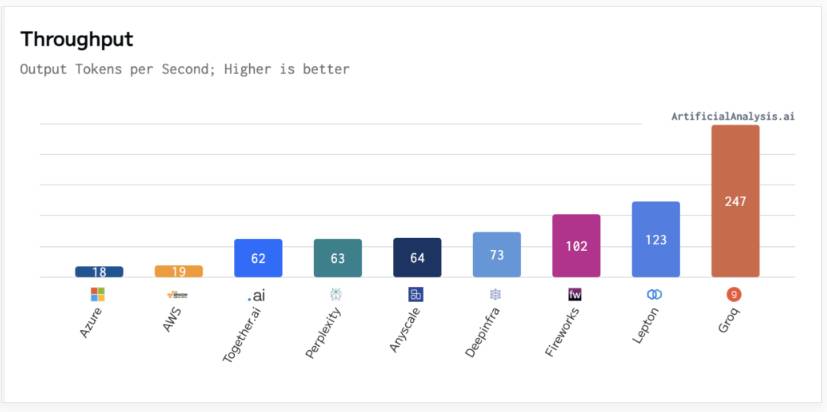

另一方面,Groq官網又提到,其任務是設立GenAI推算速度提供一個新標準,實現生活上的即時AI應用。該企稱,LPU推算引擎亦可以替AI語言應用等具順序元件的運算密集應用,提供全球最快的推算服務。的確,已有不少用戶於社交平台展示Groq與ChatGPT的比較影片,顯示Groq生成答案的速度遠超ChatGPT。

AI晶片Groq技術崛起 ︳ 專家:現階段取代Nvidia(美:NVDA)的 GPU 仍然太貴

Groq 一夜爆紅,憑藉其響應速度同可能不需要 GPU 的新技術,不過有專家稱,現階段想用它取代輝達 (NVDA-US) 的 GPU 仍然太貴,價錢而言並不划算。有評論就指出,Groq的整體成本是 NVIDIA GPU 的30倍之多,考量到Groq晶片的記憶體只有230MB,運行實際模型需使用572片晶片,總成本高達到1144萬美元。相比之下,使用8片H100的系統在性能上可與Groq系統匹敵,但硬體成本只需30萬美元,加上年電費約2.4萬美元,若以三年計算,總運營成本遠低於Groq系統。

AI晶片Groq技術崛起︳業內正設法降低對Nvidia GPU依賴

事實上除了Groq的崛起外,微軟也在採取行動,計劃推出一款新的網絡卡,以提升其AI晶片Maia的效能,The Information網站消息稱,微軟正開發一款新網絡卡,作為輝達網絡卡ConnectX-7替代品。進一步降低對Nvidia GPU的依賴。